Bạn gõ một câu hỏi vào ChatGPT, bấm Enter, và bụp — nó trả lời ngay. Nhanh đến mức nhiều người tưởng bên trong có một người ngồi trực tổng đài. Nhưng không. Thứ đang chạy phía sau là một mô hình AI được huấn luyện cực lớn, làm việc theo cơ chế khá… “thực dụng”: dự đoán từ/đơn vị ký tự tiếp theo trong câu trả lời dựa trên những gì bạn vừa đưa vào. Nghe đơn giản ghê ha? Mà chính cái “đơn giản” đó, khi phóng to lên hàng tỷ tham số và dữ liệu huấn luyện khổng lồ, lại tạo ra hiệu ứng hội thoại mượt như thật. GPT-4 Technical Report mô tả các mô hình GPT là Transformer-based, được pre-train để dự đoán token tiếp theo.

Thôi, mình kể theo kiểu đời thường. Bạn cứ tưởng ChatGPT như một “máy hoàn thành câu” siêu xịn: bạn đưa nửa câu, nó đoán phần còn lại. Nhưng nó không đoán bừa đâu, nó đoán dựa trên những mẫu ngôn ngữ đã học, cộng thêm quá trình “chỉnh thói quen” để trả lời hữu ích hơn. Và thế là thành ra… một chatbot biết nói chuyện!

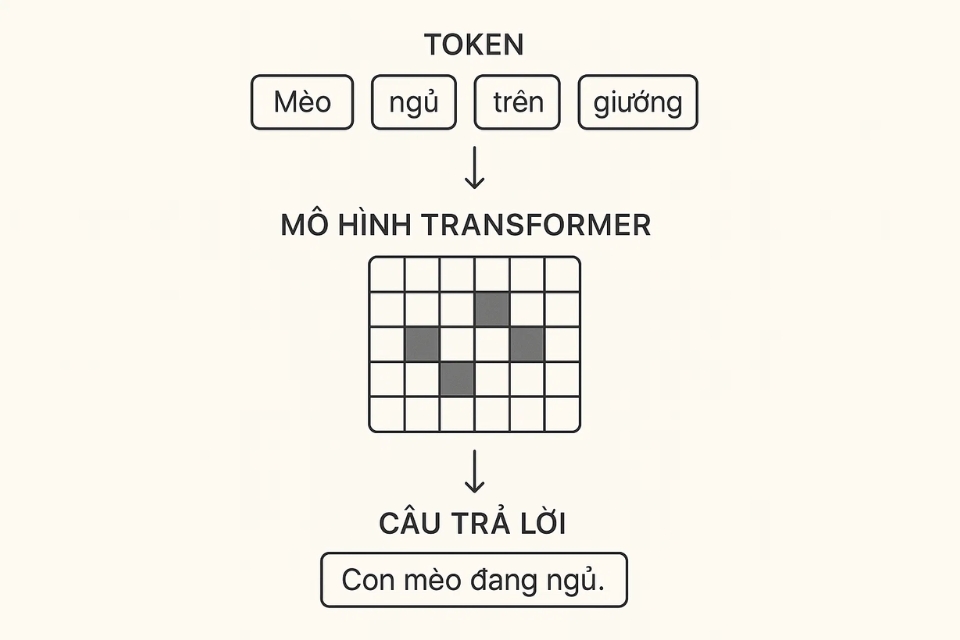

1) Bên trong ChatGPT có gì? Token, Transformer và trò “đoán tiếp”

Điểm mấu chốt nằm ở từ token. Token có thể hiểu nôm na là mảnh nhỏ của văn bản (không hẳn là một từ; đôi khi là vài ký tự). Khi bạn nhập câu hỏi, Word ư? Không, ChatGPT sẽ “băm” câu hỏi của bạn thành token, rồi bắt đầu tính toán: token tiếp theo nên là gì để tạo ra câu trả lời hợp lý.

Còn “Transformer” là kiến trúc mô hình (kiểu bộ não) giúp nó nhìn ngữ cảnh rộng, liên kết các phần trong câu, giữ mạch ý, và tạo ra văn bản trôi chảy. GPT-4 Technical Report nói thẳng: GPT-4 là Transformer-based và được huấn luyện theo kiểu next-token prediction.

Bạn hỏi: “Vậy nó có hiểu không?”

Nó không “hiểu” kiểu có trải nghiệm như con người. Nhưng nó học được rất nhiều quy luật ngôn ngữ và tri thức từ dữ liệu, nên khi nói chuyện bạn sẽ thấy nó phản hồi có vẻ hiểu. Cảm giác đó đôi khi mạnh đến mức… hơi ảo.

2) ChatGPT được “dạy” như thế nào? Pre-training rồi mới ‘uốn nắn’

ChatGPT không sinh ra đã biết lịch sự, biết chia ý, biết từ chối yêu cầu nguy hiểm. Nó thường trải qua 2 chặng lớn:

Chặng 1: Pre-training (huấn luyện nền)

Ở giai đoạn này, mô hình đọc rất nhiều văn bản và học cách dự đoán token tiếp theo. Giống như bạn cho nó luyện “điền vào chỗ trống” liên tục, từ đơn giản tới phức tạp, cho tới khi nó có thể tạo ra văn bản khá tự nhiên.

Chặng 2: Post-training / Alignment (căn chỉnh để hợp ý người dùng)

Đây là phần biến “máy đoán chữ” thành “trợ lý biết điều”. Nổi tiếng nhất là RLHF – Reinforcement Learning from Human Feedback (học tăng cường từ phản hồi của con người). Trong bài “Training language models to follow instructions with human feedback” (InstructGPT), nhóm nghiên cứu mô tả cách dùng phản hồi của con người để tinh chỉnh mô hình sao cho hữu ích hơn, ít độc hại hơn, bám hướng dẫn hơn.

Nói nôm na: con người chấm điểm, xếp hạng câu trả lời; mô hình học theo để tăng xác suất trả lời kiểu “được việc” thay vì kiểu “nói cho hay”.

3) Khi bạn chat, chuyện gì xảy ra trong vài giây đó?

Đây là đoạn nhiều người tò mò nhất: “Tại sao nó trả lời nhanh vậy?” Quy trình thường giống thế này:

-

Nhận prompt: câu hỏi của bạn + ngữ cảnh cuộc trò chuyện trước đó (nếu có).

-

Nén vào context window: mọi thứ phải nằm trong “cửa sổ ngữ cảnh” (giới hạn token). OpenAI API có tài liệu giải thích conversation state và context window: mô hình chỉ xử lý được một lượng token nhất định cho mỗi lượt.

-

Tạo câu trả lời từng token: mô hình đoán token tiếp theo, rồi tiếp theo nữa… cho tới khi kết thúc.

-

Áp các ràng buộc an toàn/hành vi (tùy hệ thống): để hạn chế nội dung nguy hiểm, vi phạm, hoặc không phù hợp.

-

Xuất ra thành văn bản bạn nhìn thấy.

Một chi tiết thú vị: với một số mô hình “reasoning”, hệ thống có thể tạo ra “reasoning tokens” (dạng suy luận nội bộ), rồi không hiển thị phần đó, chỉ hiện câu trả lời cuối. Tài liệu của OpenAI API có nhắc: reasoning tokens có thể được tạo ra rồi bị loại khỏi ngữ cảnh hiển thị, trong khi vẫn chiếm dung lượng tính toán.

4) Vì sao ChatGPT đôi lúc trả lời sai, hoặc “tự tin quá”?

Nói ngắn gọn: vì nó tối ưu để tạo ra câu trả lời có vẻ hợp lý về mặt ngôn ngữ, chứ không phải là một “cỗ máy kiểm chứng sự thật” mặc định. Nếu dữ liệu huấn luyện có chỗ thiếu, hoặc prompt của bạn mơ hồ, hoặc câu hỏi yêu cầu số liệu cập nhật mà nó không có… nó có thể điền vào khoảng trống bằng thứ nghe rất trôi chảy. Người ta hay gọi hiện tượng này là “hallucination”.

Vậy nên cách dùng khôn là:

-

hỏi rõ bối cảnh, ràng buộc;

-

yêu cầu nó nêu giả định;

-

những thứ quan trọng thì kiểm tra nguồn.

Bạn coi nó như đồng đội viết nháp cực nhanh. Còn phần “chốt đúng” vẫn nên có bạn.